相關文章

Related Articles詳細介紹

| 品牌 | 津發科技 | 適用領域 | 科研 |

|---|---|---|---|

| 產地 | 國產 | 加工定制 | 否 |

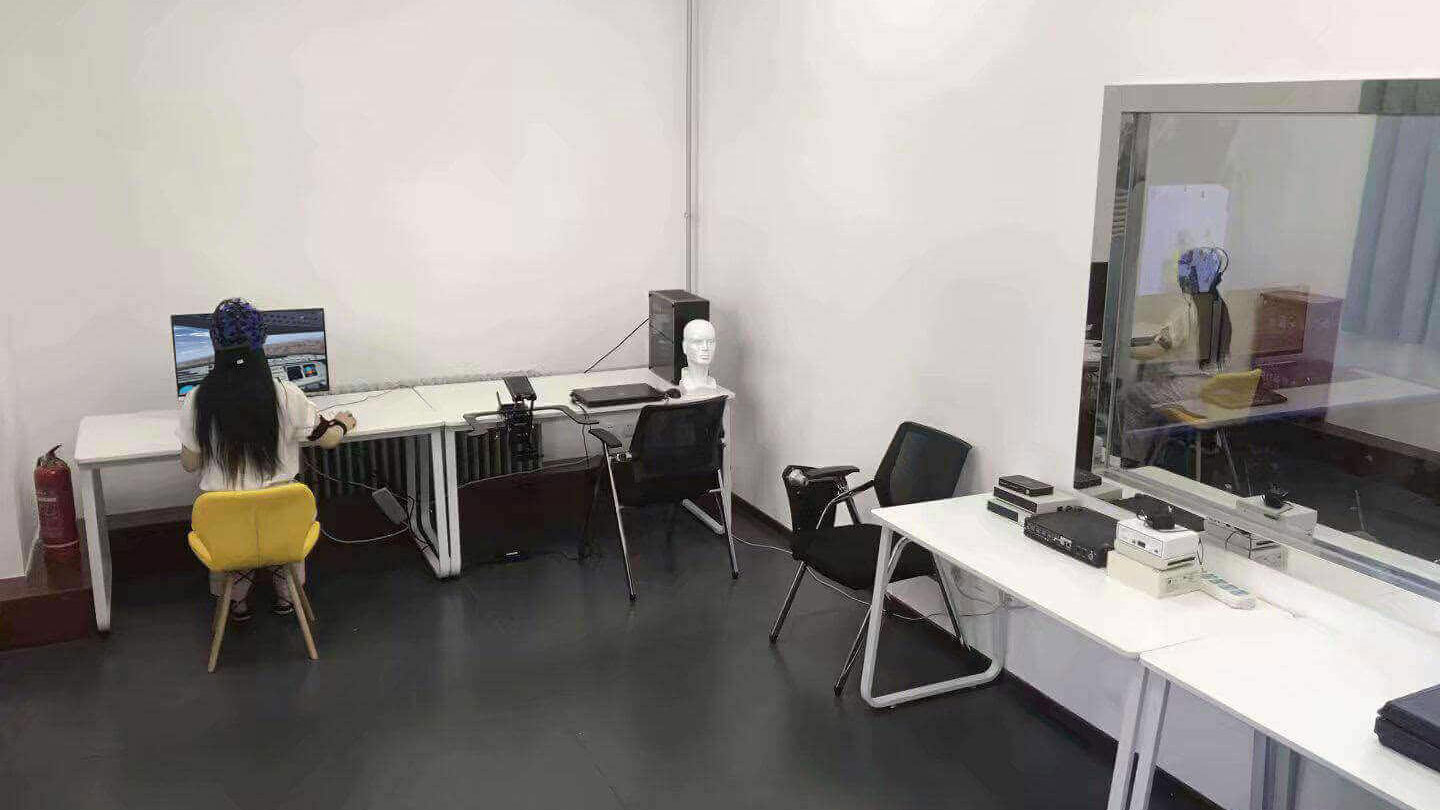

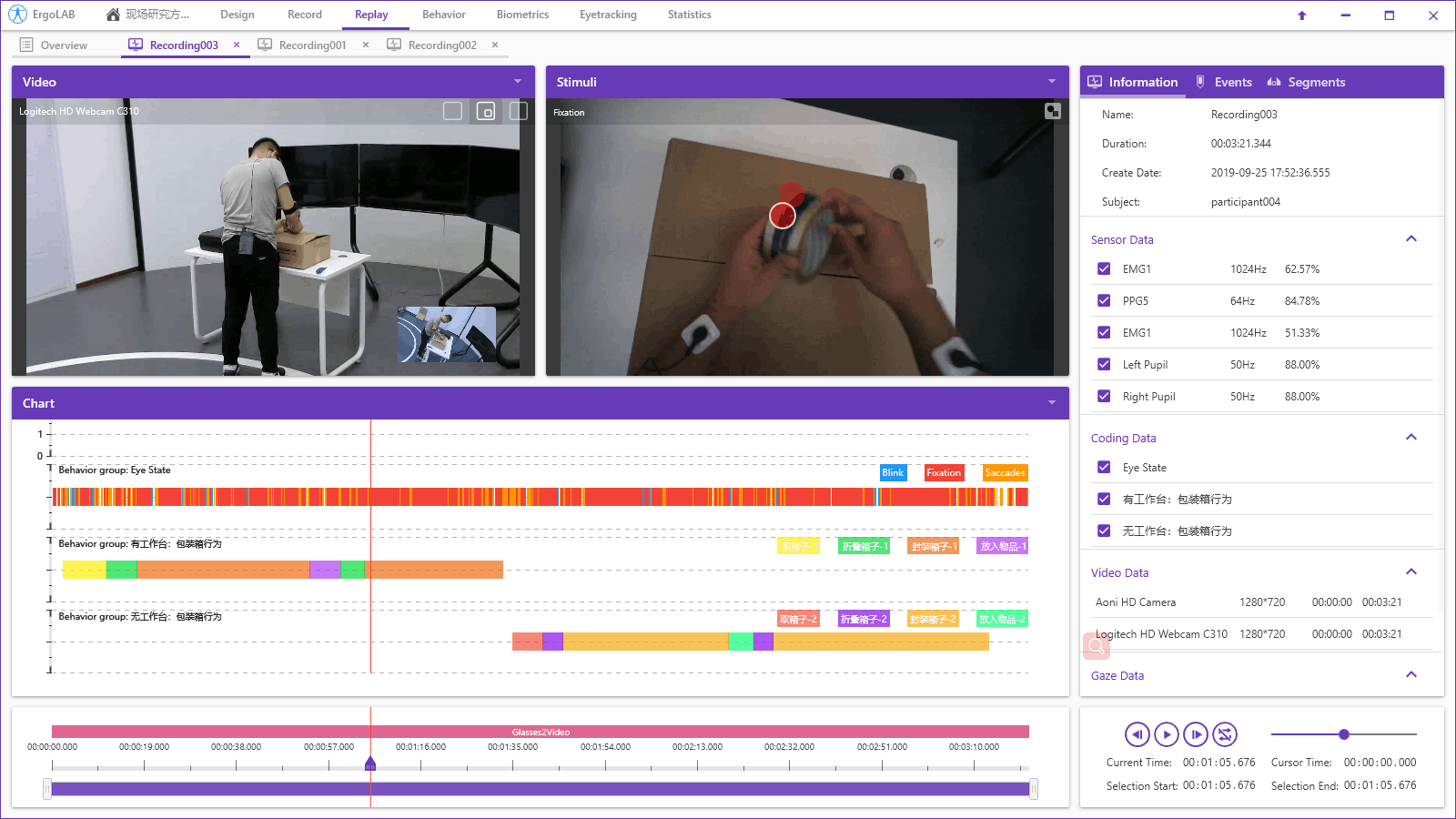

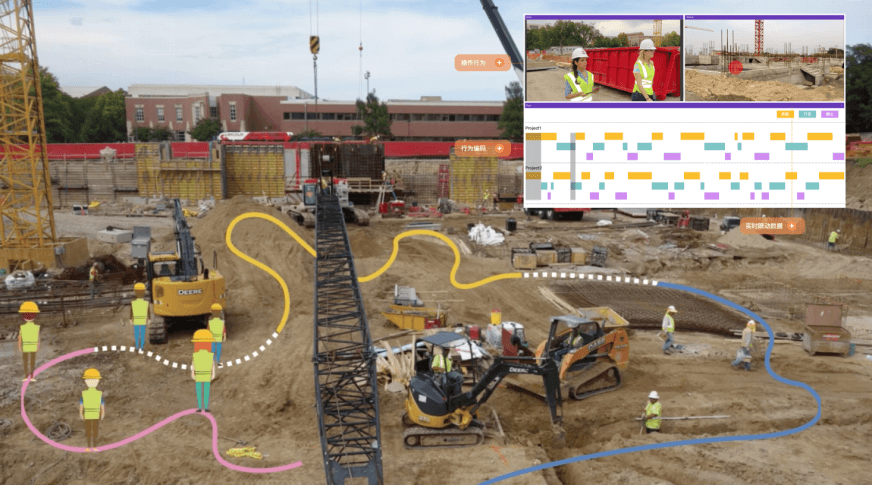

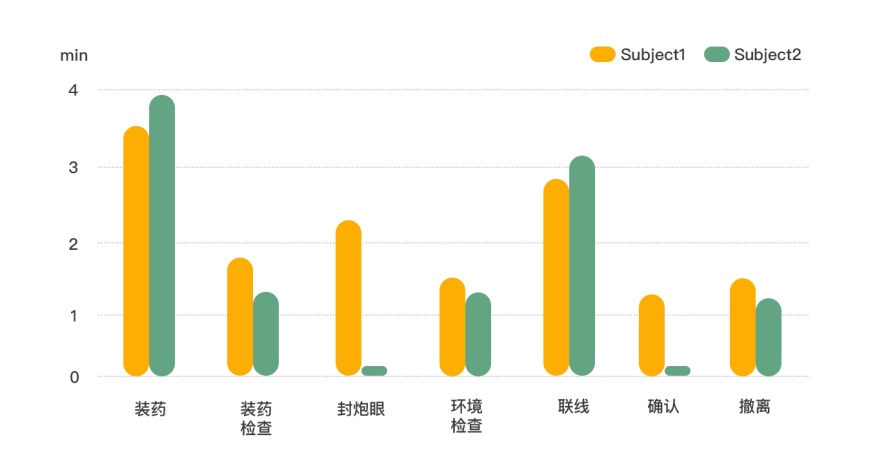

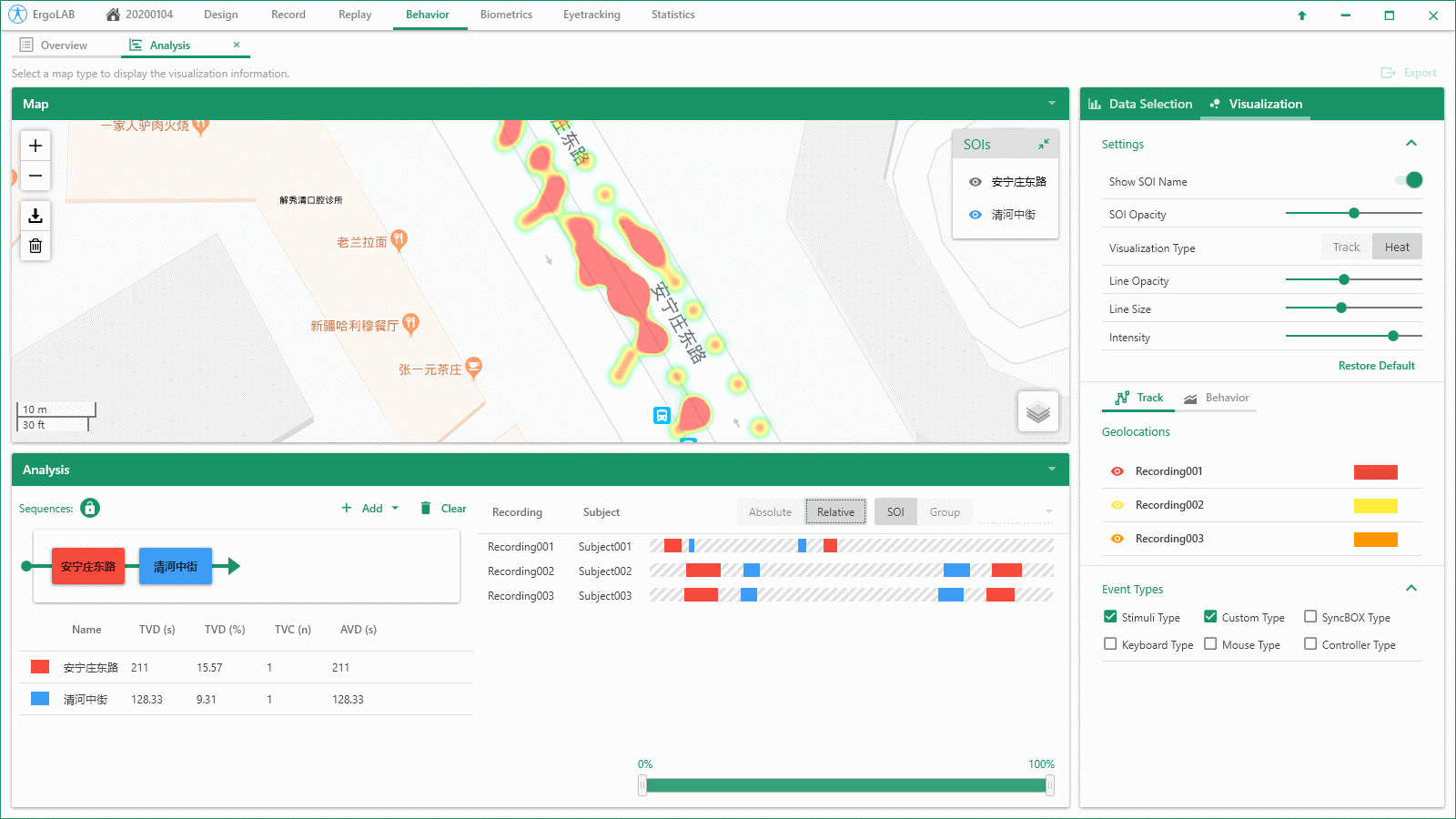

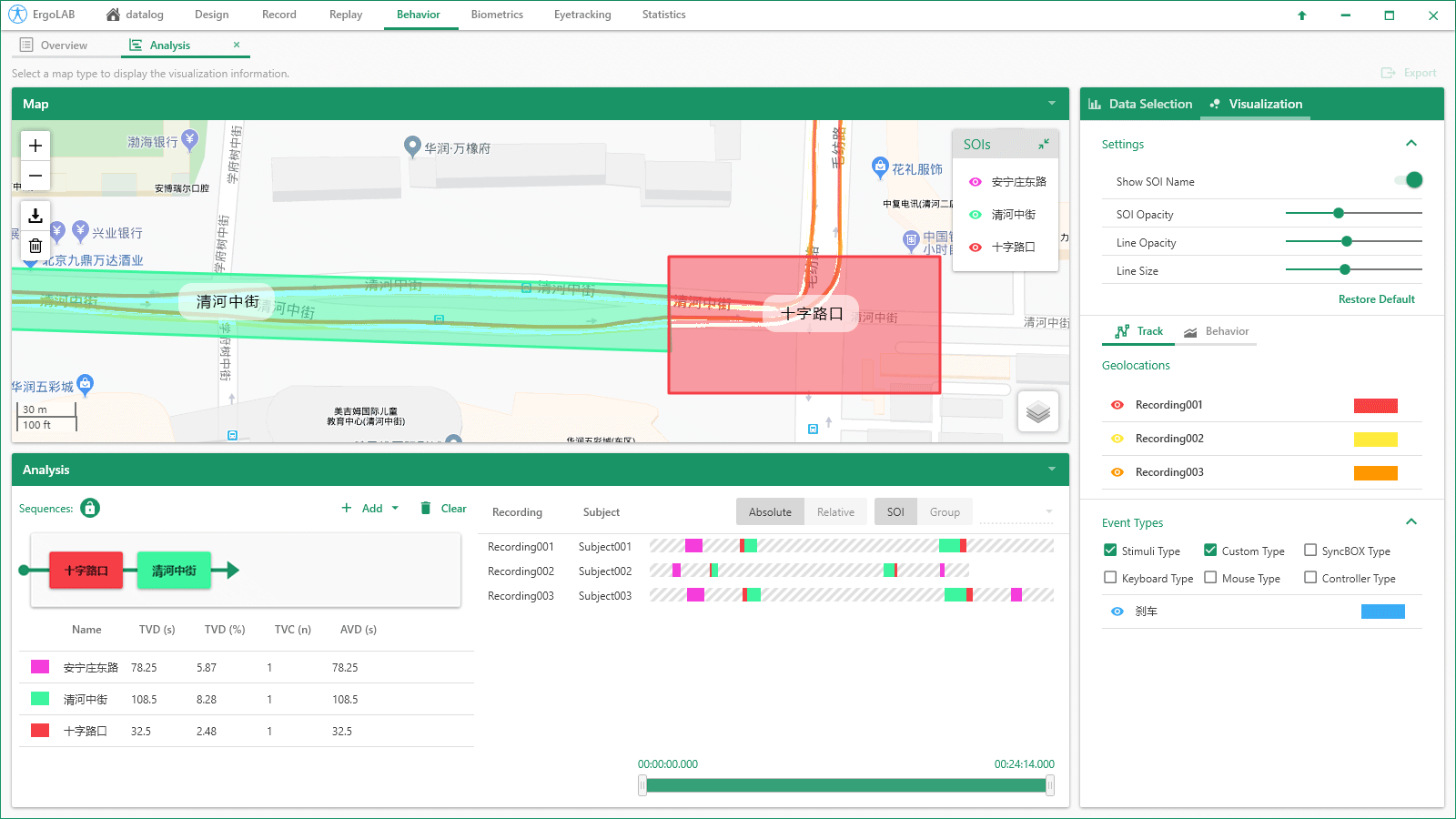

ErgoLAB Behavior行為觀察分析模塊,采用標準攝像頭錄制行為視頻,實時獲取被研究對象的動作,姿勢,運動,位置,表情,情緒,社會交往,人機交互等各種活動,記錄并分析其狀態與表現形式,形成行為-時間-頻次數據庫,記錄與編碼分析個體在活動中的行為頻次或習慣性動作的特點等。通過交互行為觀察,探索心理、生理的外在表現,進一步了解人們行為與心理反應的相互關系。

ErgoLAB人機環境同步云平臺可人-機-環境多維度數據的同步采集與綜合分析,包括眼動追蹤、生理測量、生物力學、腦電、腦成像、行為、人機交互、動作姿態、面部表情、主觀評 價、時空行為、模擬器、物理環境等,為科學研究及應用提供完整的數據指標。平臺可完成完整的實驗和測評流程,包括項目管理-試驗設計-同步采集-信號處理-數據分析-人工智能應用-可視化報告,支持基于云架構技術的團體測試和大數據云管理。

人機工程、人的失誤與系統安全、人機工效學、工作場所與工效學負荷等

從安全的角度和著眼點,運用人機工程學的原理和方法去解決人機結合面安全問題

人-車-路-環境系統的整體研究,有助于改善駕駛系統設計、提高駕駛安全性、改善道路環境等